Featured Posts

ALL

TFX 머신러닝 파이프라인 사용하기

팀에서 필요한 학습 파이프라인 구축하기

핑퐁팀에서는 루다의 대화 성능을 지속적으로 발전시키기 위해 Continual Learning을 연구하고 있어요. 이를 위해 새로운 데이터를 받으면 모델을 학습하고, 평가하는 일련의 과정을 수행해야 하는데, 이 모든 과정에 사람이 직접 개입하는 것은 너무 효율적이지 않았어요. 그래서 반복되는...

GitHub Actions로 App 자동으로 배포하기

루다와 함께 사용하는 메신저 'Nutty' 자동으로 배포하기

핑퐁팀은 2022년 상반기에 루다와 유저를 만나게 하는 수단으로 더 이상 페이스북 메신저를 사용하지 않고 자체 메신저 앱을 개발하기로 결정했습니다. 저희는 빠르게 MVP 형식의 메신저 앱을 완성하여 배포한 후 지속적인 업데이트를 통해 앱의 완성도를 올리자는 계획을 세웠고,...

VPT: 다이아몬드 곡괭이를 만들기 위한 여정

OpenAI에서 어떻게 다이아몬드 곡괭이를 만들었는지 알아봅니다. (VPT)

AWS Inferentia를 이용한 모델 서빙 비용 최적화: 모델 서버 비용 2배 줄이기 2탄

우당탕탕 Inferentia 배포하기

지난 글에서는 AWS Inferentia 소개와 사용법, GPU와의 성능 비교 등을 설명해 드렸어요! 이번 글에서는 Inferentia를 실제 서비스에 도입하기 위해 핑퐁팀에서 어떤 과정들을 거쳤는지 소개해드릴게요.😋 preview ...

쿠버네티스에서 노드가 추가될 때마다 슬랙 알람 쏘기

나만의 Kubernetes event watcher 만들기

AWS의 Elastic Kubernetes Service나 GCP의 Google Kubernetes Engine 등, 대부분의 대형 클라우드 서비스는 독자적인 관리형 쿠버네티스 서비스를 제공하고 있습니다. 이러한 서비스는 해당 클라우드 벤더사에서 제공하는 컴퓨팅 엔진을 간편하게 연동할 수 있다는 장점을 갖습니다. Cluster Autoscaler를 활용하면 노드...

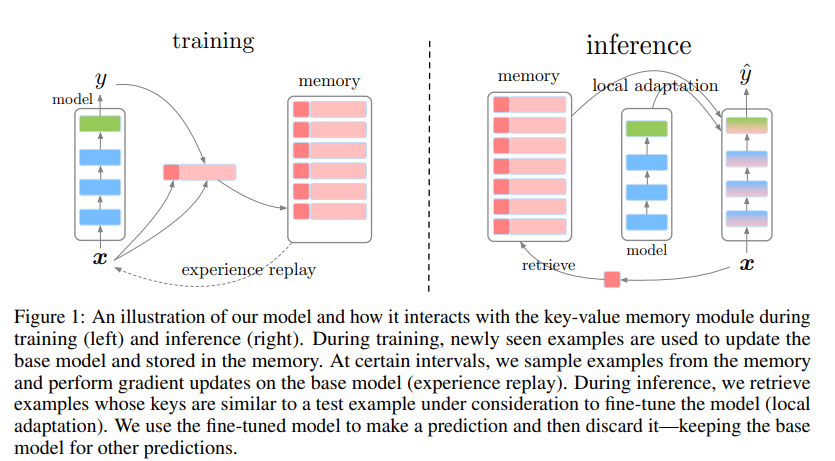

Continual Learning: 꾸준히 성장하는 모델을 만들기 위한 기술

주제별로 알아보는 continual learning

Continual Learning은 지속적으로 들어오는 데이터 스트림을 학습하기 위한 방법입니다. 데이터가 지속적으로 주어짐에 따라 데이터의 분포 혹은 데이터가 다루는 태스크가 변화하고, 모델은 현재 주어진 데이터를 학습할 때 기존에 배운 지식을 일부 잃기 마련입니다. 이러한 현상을 Catastrophic Forgetting이라고...

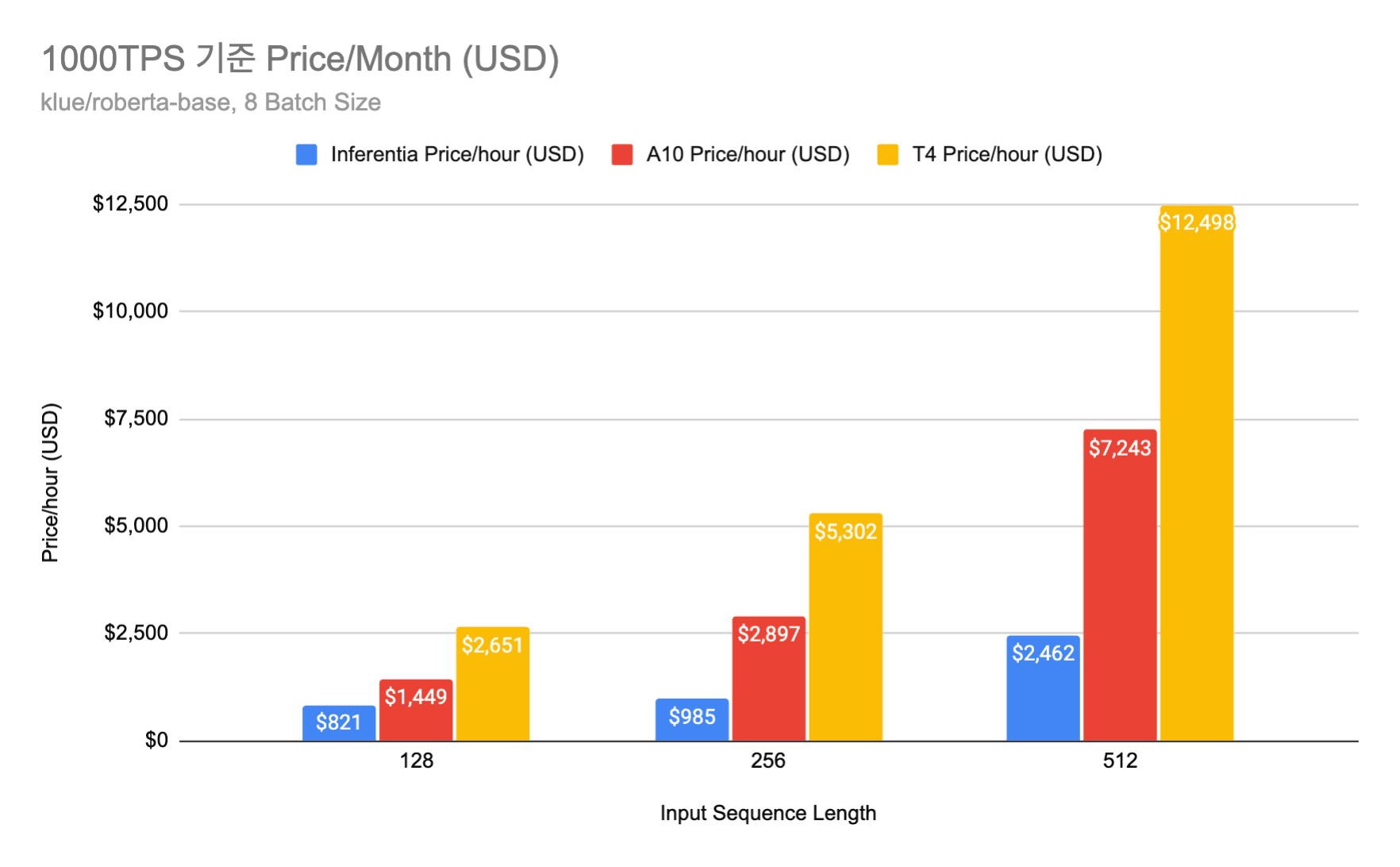

AWS Inferentia 를 이용한 모델 서빙 비용 최적화: 모델 서버 비용 2배 줄이기 1탄

AWS 고객감사 특별 할인... 모델 서빙 비용 최대 80% 초특가 할인전

머신러닝 엔지니어링(MLE)팀에서는 제품에 사용되는 여러 딥러닝 모델을 최대한 낮은 지연 시간과 적은 비용으로 서빙하기 위해서 여러 하드웨어 및 소프트웨어 최적화 기법을 실험해보고 실제 프로덕트에 적용하고 있습니다. 높은 수준으로 최적화된 모델 서빙은 실제 서비스에서 더 큰...

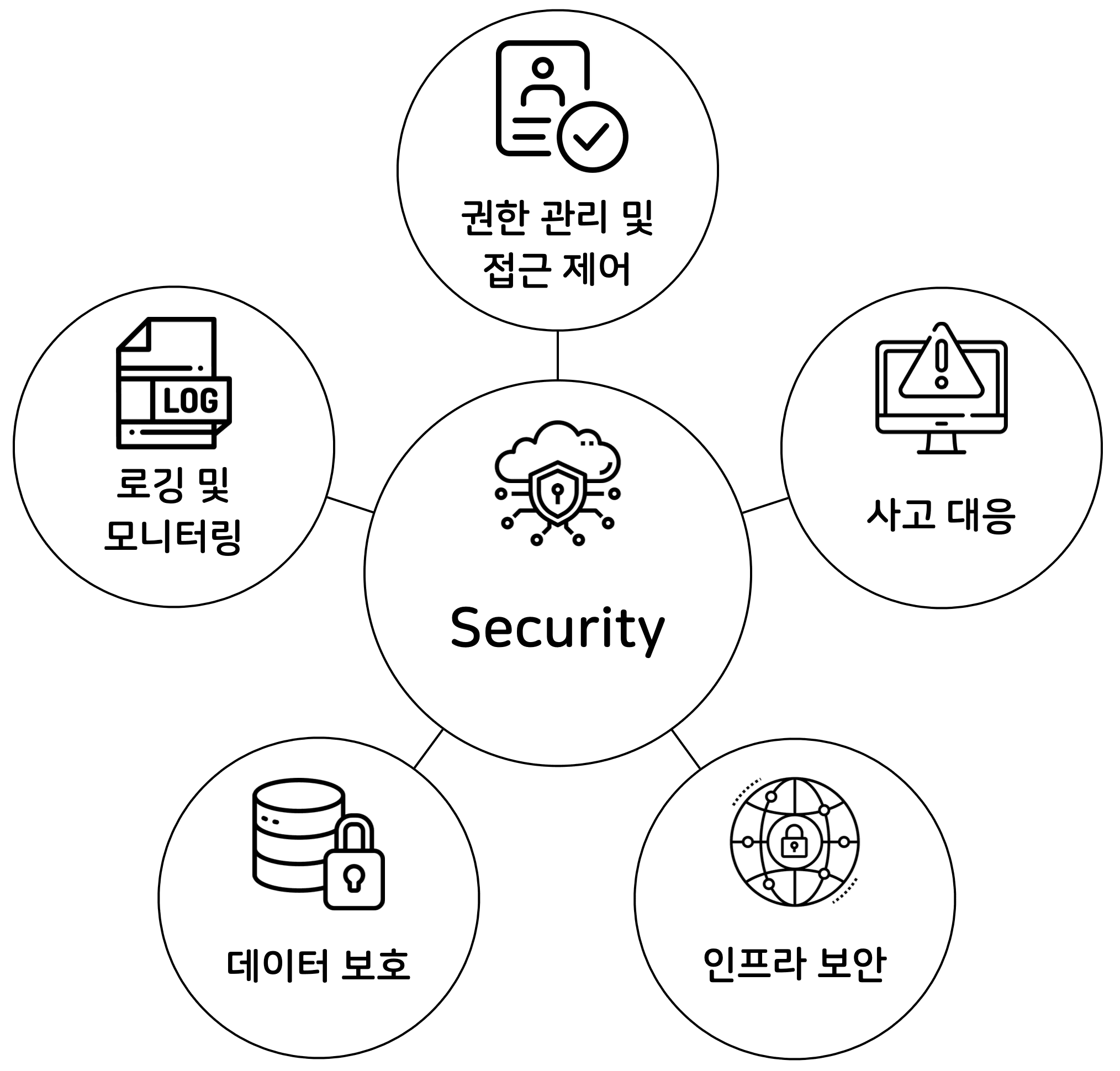

개발자를 위한 AWS 클라우드 보안 (3) - 인프라 보안과 사고 대응

이것만 알아도 클라우드 보안 마스터

핑퐁팀에서 AWS 보안 강화를 위해 작업했던 내용을 AWS Well-Architected Framework와 함께 소개하는 마지막 글로, 인프라 보안 영역과 사고 대응 영역을 소개하려고 합니다. 이전 내용이 궁금하신 분들은 1편과 2편에서 확인하실 수 있습니다. ...

ACL 2022 Review

핑퐁팀과 함께하는 ACL 2022 Review

올해로 60회를 맞은 Annual Meeting of the Association for Computational Linguistics (ACL)는 자연어 처리 분야 최고의 국제 컨퍼런스로서 최신 NLP 연구들이 발표되는 행사입니다. 엔데믹 상황으로 접어들면서 올해 ACL은 오프라인과 온라인에서 동시에 하이브리드 형태로 진행되었습니다. 저희 핑퐁팀의 이성현님,...

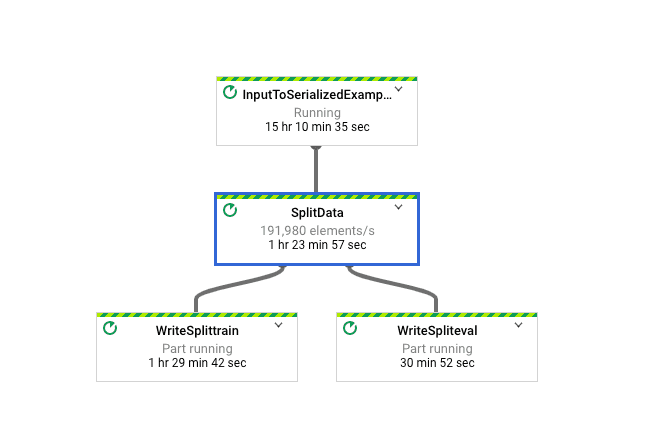

Apache Beam으로 머신러닝 데이터 파이프라인 구축하기 2편 - 개발 및 최적화

대규모 머신러닝 데이터 파이프라인 개발하고 최적화하기

지난 글에서는 핑퐁팀이 어떻게 Apache Beam을 도입하였는지를 설명드렸어요! 이번 글에서는 본격적으로 유지보수성을 높이면서 어떻게 머신러닝 데이터 파이프라인을 개발하였는지 차근차근 설명해 드릴게요. 😄 ...