Featured Posts

Machine_Learning

하나의 조직에서 TensorFlow와 PyTorch 동시 활용하기

불타는 텐서 흐름!

보통 제품이 있는 조직은 TensorFlow를, 리서치 조직은 PyTorch를 활용하는 것이 좋다고 알려져 있습니다. 그리고 하나의 조직에서는 하나의 프레임워크만 사용하는 것이 일반적이죠. 하지만 핑퐁팀의 형태는 다소 특이합니다. TensorFlow와 PyTorch를 동시에 사용하고 있습니다. 어떻게 둘 다 동시에...

딥러닝 모델 서비스 A-Z 2편 - Knowledge Distillation

난 선생이고 넌 학생이야

핑퐁팀이 내부적으로 활용하는 대형 언어 모델은 실제 서비스화하기에는 연산량이 많고, 많은 메모리를 요구합니다. 이런 모델을 실제로 활용하기 위해서는 잘 알려진 경량화 기법을 적용해야 하는데, 그 중 가장 대표적인 Knowledge Distillation 방법을 적용한 사례를 소개해보고자 합니다. ...

EMNLP 2020 프리뷰

알아두면 쓸데있는 신비한 EMNLP 2020! 저희가 준비해보았습니다.

Conference on Empirical Methods in Natural Language Processing (EMNLP)은 자연어 처리(NLP) 분야를 주도하는 국제 컨퍼런스 중 하나로 매년 많은 NLP 연구자들이 주목하는 학회입니다. 올해 EMNLP는 COVID-19로 인해서 온라인 형식으로 진행됩니다. 그래서 핑퐁팀은 메인 컨퍼런스가 진행되는...

과연 GPT-3는 얼마나 똑똑한 걸까?

여러 분야의 문제를 통해 GPT-3의 '지능'을 평가하는 방법에 대해서 알아봅니다.

핑퐁팀 ML 세미나, 그 여섯 번째

핑퐁 ML 리서치 사이언티스트들의 시즌 6 세미나 자료

안녕하십니까? 이번 여름은 언제 왔는지도 모르게 조용히 지나갔습니다. 저희 사이언티스트들이 여름에 진행한 시즌 6 세미나 발표자료를 갈무리하여 올립니다. 본 세미나는 2020년 7월 말에서 9월까지 이전 시즌과 동일하게 주제 제한 없이 매주 진행하였습니다. 그럼에도 불구하고 이번 시즌 세미나는 크게...

GPT-3의 다섯 가지 한계

GPT-3가 대단한 모델이기는 하지만 완벽하지는 않습니다. 이번 글에서는 GPT-3의 5가지 한계에 대해 알아봅니다.

GPT-3, 인류 역사상 가장 뛰어난 언어 AI

Open AI에서 발표한 GPT-3에 대해서 같이 이야기합니다

뛰어난 언어 능력으로 인터넷에서 화제가 되고 있는 언어 생성 모델 GPT-3. 이 모델이 어떤 능력을 가지고 있고, 어떻게 이런 능력을 갖게 되었는지 알아봅니다. ...

핑퐁팀 ML 세미나, 그 다섯 번째

핑퐁 ML 리서치 사이언티스트들과 엔지니어들의 시즌 5 세미나 자료

안녕하십니까? 여러가지로 혼란스러웠던 2020년도 반 넘게 지나가고 있습니다. 저희 사이언티스트들과 엔지니어들의 시즌 5 세미나 발표자료를 갈무리하여 올립니다. 본 세미나는 2020년 4월, 5월 동안 매주 진행되었으며, 지난 시즌과 마찬가지로 주제의 제한 없이 자유롭게 시작했습니다. 저번 시즌과 마찬가지로 Transformer를 많이...

핑퐁팀과 함께하는 ACL 2020 리뷰

ACL 2020에 발표되었던 논문들을 추려서 리뷰해보았습니다.

Annual Meeting of the Association for Computational Linguistics (ACL)는 자연어 처리(NLP) 분야를 주도하는 주요 국제 컨퍼런스 중 하나로, 매년 많은 NLP 연구자들이 주목하는 학회입니다. 이번 ACL 2020은 COVID-19로 인해서 여타 다른 학회들처럼 온라인 형식으로 진행되었습니다. 이에...

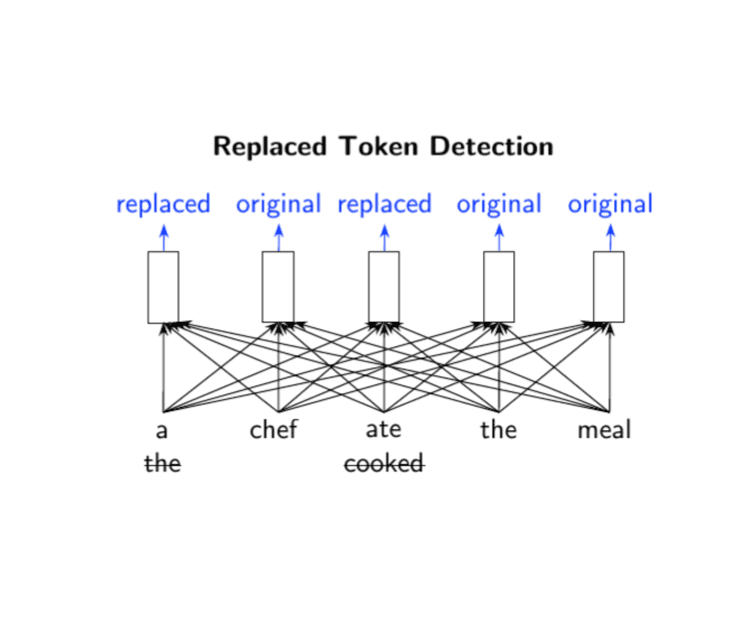

꼼꼼하고 이해하기 쉬운 ELECTRA 논문 리뷰

Review of ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

이번 ICLR 2020에서 구글 리서치 팀은 새로운 pre-training 기법을 적용한 language model, ELECTRA (Efficiently Learning an Encoder that Classifies Token Replacements Accurately)를 발표하였습니다. 기존 BERT를 비롯한 많은 language model들은 입력을 마스크 토큰으로 치환하고 이를 치환 전의...