Featured Posts

ALL

과연 GPT-3는 얼마나 똑똑한 걸까?

여러 분야의 문제를 통해 GPT-3의 '지능'을 평가하는 방법에 대해서 알아봅니다.

슈퍼휴먼 AI를 꿈꾸는 루다의 대화 구성

더 이상 외로운 사람은 없다

핑퐁팀의 비전은 Towards Superhuman Open-domain Conversational AI 입니다. 사람만큼 좋은 대화 상대, 더 나아가서 사람보다 대화 상대로서 더 선호되는 슈퍼휴먼 AI를 만드는 게 목표죠! 목표를 이루기 위해 핑퐁팀은 올해 6월에 ML 기술을 기반으로 만든 챗봇...

슈퍼휴먼 AI를 만드는 핑퐁팀의 10가지 컬처 코드

핑퐁팀은 어떻게 일하나요?

슈퍼휴먼 AI를 목표로 하는 스캐터랩 핑퐁팀은 탁월한 사람들이 모여 멋진 제품과 문화를 만드는 귀여운 팀입니다😊 원대한 목표를 이루기 위해 핑퐁팀은 스캐터랩 컬처코드 10가지를 따르고 있어요. 핑퐁팀 문화의 기반이 되는 10가지 컬처코드에 대해 알아볼까요? ...

쿠버네티스(Kubernetes)를 활용한 안정적이고 효율적인 운영 환경 구성하기

배포? 더이상 두렵지 않아요

핑퐁팀에서는 딥러닝 Model 서버를 포함한 많은 수의 서버들을 운용하고 있고, 이를 Kubernetes 상에서 효율적으로 운영하고 있습니다. 이번 글에서는 핑퐁팀이 Kubernetes를 활용하여 어떻게 안정적이고 효율적인 운영 환경을 구성했는지 소개해드리고자 합니다. \[Continuous Delivery]\( ...

핑퐁팀 ML 세미나, 그 여섯 번째

핑퐁 ML 리서치 사이언티스트들의 시즌 6 세미나 자료

안녕하십니까? 이번 여름은 언제 왔는지도 모르게 조용히 지나갔습니다. 저희 사이언티스트들이 여름에 진행한 시즌 6 세미나 발표자료를 갈무리하여 올립니다. 본 세미나는 2020년 7월 말에서 9월까지 이전 시즌과 동일하게 주제 제한 없이 매주 진행하였습니다. 그럼에도 불구하고 이번 시즌 세미나는 크게...

GPT-3의 다섯 가지 한계

GPT-3가 대단한 모델이기는 하지만 완벽하지는 않습니다. 이번 글에서는 GPT-3의 5가지 한계에 대해 알아봅니다.

GPT-3, 인류 역사상 가장 뛰어난 언어 AI

Open AI에서 발표한 GPT-3에 대해서 같이 이야기합니다

뛰어난 언어 능력으로 인터넷에서 화제가 되고 있는 언어 생성 모델 GPT-3. 이 모델이 어떤 능력을 가지고 있고, 어떻게 이런 능력을 갖게 되었는지 알아봅니다. ...

핑퐁팀 ML 세미나, 그 다섯 번째

핑퐁 ML 리서치 사이언티스트들과 엔지니어들의 시즌 5 세미나 자료

안녕하십니까? 여러가지로 혼란스러웠던 2020년도 반 넘게 지나가고 있습니다. 저희 사이언티스트들과 엔지니어들의 시즌 5 세미나 발표자료를 갈무리하여 올립니다. 본 세미나는 2020년 4월, 5월 동안 매주 진행되었으며, 지난 시즌과 마찬가지로 주제의 제한 없이 자유롭게 시작했습니다. 저번 시즌과 마찬가지로 Transformer를 많이...

핑퐁팀과 함께하는 ACL 2020 리뷰

ACL 2020에 발표되었던 논문들을 추려서 리뷰해보았습니다.

Annual Meeting of the Association for Computational Linguistics (ACL)는 자연어 처리(NLP) 분야를 주도하는 주요 국제 컨퍼런스 중 하나로, 매년 많은 NLP 연구자들이 주목하는 학회입니다. 이번 ACL 2020은 COVID-19로 인해서 여타 다른 학회들처럼 온라인 형식으로 진행되었습니다. 이에...

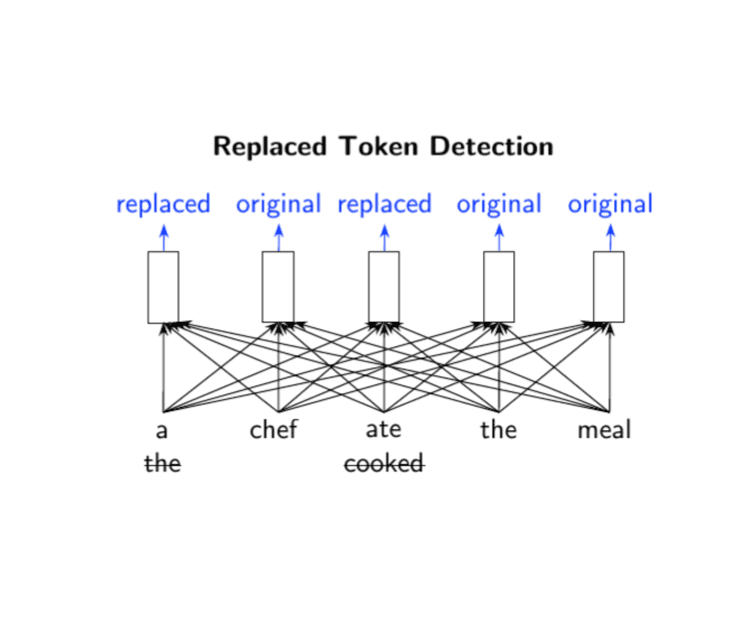

꼼꼼하고 이해하기 쉬운 ELECTRA 논문 리뷰

Review of ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

이번 ICLR 2020에서 구글 리서치 팀은 새로운 pre-training 기법을 적용한 language model, ELECTRA (Efficiently Learning an Encoder that Classifies Token Replacements Accurately)를 발표하였습니다. 기존 BERT를 비롯한 많은 language model들은 입력을 마스크 토큰으로 치환하고 이를 치환 전의...